ChatGPT ist kein philosophischer Logiker – und das sollten auch Schülerinnen und Schüler wissen

Die Antworten von ChatGPT sind betörend. Viel wurde daher über die Auswirkungen von ChatGPT auf Schule und Hochschule geschrieben, Banales und Bedeutendes. Ein wichtiger Aspekt wird dabei aber wenig beachtet, dem möchte ich mich hier kurz widmen.

Der Mensch verknüpft Texte mit Bedeutung, diese Bedeutungen werden in Korrelation gesetzt. Wir besitzen so etwas wie Wahrheitsfähigkeit, so würden es zumindest manche Philosoph*innen sehen. Mit der Frage, wie man wahre von falschen Aussagen unterscheiden kann, beschäftigen sich verschiedene philosophische Ansätze. Die philosophische Logik, die Ontologie und die Erkenntnistheorie helfen uns bei der Einordnung. Kurzum: der Mensch möchte weitergeben, was der Fall ist. Text ist für den Menschen Repräsentation.

Was macht dagegen ChatGPT? ChatGPT ist eine sogenannte schwache künstliche Intelligenz (KI). Schwache KI soll den Menschen bei konkreten Anwendungsproblemen unterstützen, im Gegensatz zu starker KI hat es aber nicht den Anspruch, komplexe Aufgaben eigenständig zu lösen.

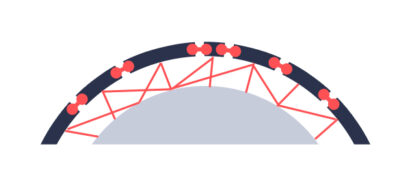

ChatGPT funktioniert so, dass die Textfragmente keine Zuordnung zu Bedeutungen haben. Stark vereinfacht ausgedrückt: er sucht in seiner Datenbank nach Textmustern, die in Beziehung mit einer gestellten Frage stehen. Die gefundenen Textmuster setzt er aufgrund von formalen Kriterien zusammen. Mit errechneten Wahrscheinlichkeiten versucht der Bot, vorherzusagen, wie ein Satz sinnvoll fortgesetzt werden kann. Diese Fähigkeiten von ChatGPT wurden in mehreren Phasen optimiert (selbstüberwachtes Lernen, überwachtes Lernen, bestärkendes Lernen). Es werden also Textteile in Vektorräume übersetzt, verarbeitet und anschließend zusammengeklebt.

Wahrheit kann in diesem Zusammenhang kein Kriterium für ChatGPT sein. Er versucht, aus den Daten, die ihm zur Verfügung stehen, mit Hilfe von Algorithmen Texte zu erstellen. Diese Texte sind losgelöst von Repräsentation. ChatGPT verfügt nicht über so etwas wie ein strukturiertes Weltwissen.1

ChatGPT erzeugt Textmuster, von denen der Mensch gewohnt ist, sie als sinnvoll zu akzeptieren. Man hat also das Gefühl, dass ChatGPT sinnvolle Texte erzeugt, sehr oft sind die Ergebnisse seltsam vage und nebulös. Dabei handelt es sich aber um die Abarbeitung eines Algorithmus an einer riesigen Menge an Parametern. Die Texte haben keine Bedeutung im menschlichen Sinne, ChatGPT hat keinen Überblick über das Arrangement. Er ist also eher so etwas wie ein Polyphrasiker, manches Mal ein Bullshitter, jedenfalls aber kein philosophischer Logiker. Sprache entsteht hier über statistische Modellierung.

Von diesen Fähigkeiten des Bots sind wir geblendet und projizieren Bedeutung in die Texte. Das zeigt sich sehr deutlich bei all den veröffentlichten Antworten des Bots, bei denen es dann heißt: „ChatGPT meint dazu …“. Der Bot meint aber nicht, er konstruiert. Vergessen wir nicht: ChatGPT wurde von Menschen erfunden und programmiert, die Struktur der Datenbank haben Menschen ersonnen und die Textfragmente stammen von Menschen.

Den Unterschied zwischen Bedeutung und der Simulation von Bedeutung sollten wir auch unseren Schüler*innen bewusst machen.

Anmerkung

1 Es gibt aber sehr wohl Ansätze zu KI, die versuchen, Wissen zu strukturieren. Cyc (https://de.wikipedia.org/wiki/Cyc) verwendet seit 1984 eine eigene Ontologiesprache (Cycl), um aus Inhalten logische Aussagen zu generieren. Eliza (1966, https://de.wikipedia.org/wiki/ELIZA) verfügt über ein strukturiertes Wörterbuch.